Inteligencia Artificial e Inteligencia Humana

Corrientes de Pensamiento y el Problema Mente-Cuerpo

Las Ciencias Cognitivas son una interdisciplina que estudia la cognición integrando la Filosofía, Psicología, Lingüística, Antropología, Neurociencia y Ciencias de la Computación. El problema fundamental abordado por la Ciencia Cognitiva es el problema Mente-Cuerpo, Kim, J (2018) & Braddon-Mitchell, D., & Jackson, F. (1996).

El estudio del problema Mente-Cuerpo comienza con Aristóteles y Platón, sin embargo, fue descrito por primera vez por Rene Descartes. A partir de este problema surgieron diversos Paradigmas o corrientes de pensamiento, siendo las más importantes “El Materialismo” y el “Dualismo”.

Dualismo

El Dualismo postula que existen dos dimensiones: “La Mente” o “Res Cogitan” y “El Cuerpo” o “Res Extensa” y establece que el fenómeno de “Lo mental” no puede ser reducido a lo Material. Descartes introduce el concepto de “Conciencia” y “Autoconciencia” en donde el sujeto se atribuye a sí mismo un contenido mental. De esta manera la Mente sería una propiedad emergente, que no puede ser explicada punto a punto por la materia.

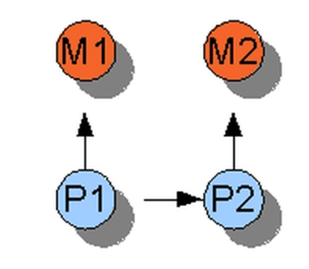

“El Dualismo de Propiedades” sostiene que las experiencias mentales, como los pensamientos, las sensaciones y los estados de conciencia, son meros «epifenómenos» o acompañamientos de los procesos físicos en el cerebro y el cuerpo, pero no tienen efectos causales sobre el mundo físico. En el siguiente diagrama se representan los estados físicos de la materia como P1 y P2, mientras que los estados mentales son representados por M1 y M2.

Por otra parte, el “Dualismo Interaccionista”, sostiene que la mente puede ejercer un impacto causal sobre el cuerpo, lo que implica que los pensamientos y los estados mentales (M1) impacta y modifica la materia (P2). Del mismo modo, los eventos físicos, como las señales nerviosas y las sensaciones corporales, pueden influir en la mente y generar experiencias mentales.

Materialismo

Por otra parte, el Materialismo, es la corriente filosófica que se opone al dualismo y sostiene que la única realidad es la materia y que los fenómenos mentales, incluida la consciencia, pueden ser explicados en términos de procesos físicos. Dentro del Materialismo existen distintas escuelas de pensamiento, siendo las principales: El conductismo, el Materialismo Reduccionista y el Funcionalismo.

Jaegwon Kim (2005, P.39), aborda el problema mente-cuerpo y cuestiona la posibilidad de que exista una mente independiente del cuerpo. Kim sostiene que las propiedades mentales están completamente determinadas por las propiedades físicas del cerebro. En otras palabras, cualquier cambio en las propiedades mentales debe tener su origen en cambios en las propiedades físicas del cerebro. Esto implica que la mente no puede tener un impacto causal independiente del cuerpo.

Conductismo

El conductismo, nace como respuesta al dualismo y se centra en el comportamiento observable, rechazando la noción de estados mentales internos. Para el conductismo, la Mente no es una entidad separada del cuerpo, sino que puede ser reducida a la conducta externa y a la respuesta observable de estímulos y respuestas. Desde un punto de vista metodológico el conductismo permite explicar la conducta de cualquier organismo con un actividad medible y registrable como, por ejemplo, movimientos corporales o interacciones con el medio.

Materialismo Reduccionista

Por otra parte, el Materialismo Reduccionista sostiene que los fenómenos mentales pueden ser explicados en términos de procesos físicos y neuronales en el cerebro. Esta teoría afirma que la mente es simplemente el resultado de la actividad del cerebro y que los estados mentales se reducen a estados físicos del cerebro, es decir, cada estado mental es numéricamente idéntico a un estado cerebral. Según el materialismo reduccionista, deberíamos, eventualmente, ser capaces de explicar todos los fenómenos mentales en términos de neurociencia y procesos cerebrales.

Para el materialismo reduccionista existe, en consecuencia, una reducción inter teórica, es decir, el lenguaje mentalista puede ser reducido al lenguaje materialista, por ejemplo: “Me siento Feliz” es equivalente a “El cerebro está liberando Dopamina por un circuito de recompensa”. De esta manera, las actividades cognitivas son actividades del sistema nervioso central y, si comprendemos los mecanismos físicos, químicos y eléctricos de las neuronas, habrá una compresión total de la conducta.

Funcionalismo

El Funcionalismo postula que los estados mentales dependen del procesamiento interno de la información. De esta manera, los estados mentales son únicamente estados funcionales y están constituidos únicamente por sus relaciones causales con otros estados mentales. Por consiguiente, un estado mental es el proceso resultante que se lleva a cabo cuando un conjunto de estímulos sensoriales (Input), produce una determinada conducta resultante (Output). Por ejemplo, un estado mental de alivio, luego de recibir un input sensorial, puede cambiar a un estado mental de dolor.

Para el funcionalismo lo importante no es la sustancia física en la que se realiza el procesamiento, sino la función que desempeña. El sistema cognitivo humano procesa la información de la misma manera que lo hace una computadora. La cognición humana y su arquitectura funcional son similares a los modelos de procesamiento de la Inteligencia Artificial (IA). De esta manera la Mente Humana es una máquina biológica compleja encargada de procesar símbolos. Los sistemas cognitivos humanos y las computadoras reciben, codifican, transforman, almacenan y recuperan información siguiendo determinadas reglas de cálculo o algoritmos (algoritmo funcional).

Finalmente, el Funcionalismo, ha sido la corriente de mayor influencia en el campo de la Neurociencia. El funcionalismo se centra en el estudio de las funciones mentales y los procesos cognitivos en lugar de enfocarse en la estructura física del cerebro. Se ha adoptado el enfoque de estudiar cómo diferentes regiones cerebrales desempeñan funciones específicas y cómo se comunican entre sí para producir comportamientos y experiencias mentales.

Inteligencia Humana

La inteligencia humana es un constructo difícil de definir y sobre el cual no existe un consenso absoluto ya que, la inteligencia, se puede descomponer en un conjunto de habilidades. Por consiguiente, el constructo inteligencia aglutina una serie de procesos de orden superior tales como: orientación espacial, planificación, memoria de trabajo y control inhibitorio. Diversos estudios demuestran que la corteza prefrontal controla las funciones ejecutivas (Raver, C. C., Blair, C. 2016) & (Hampshire, A., & Sharp, D. J. 2015)

Las funciones cognitivas superiores también se llaman funciones evolutivas porque se considera que han evolucionado a lo largo del tiempo en diferentes especies para adaptarse y sobrevivir en entornos cambiantes y desafiantes. Estas funciones son características de los organismos con sistemas nerviosos más complejos y se han desarrollado a lo largo de la evolución para permitir una mayor capacidad de procesamiento de información y una mayor adaptabilidad a diferentes situaciones.

El control inhibitorio es una función cognitiva que se refiere a la capacidad del cerebro para interrumpir o inhibir respuestas automáticas o acciones impulsivas en favor de respuestas más controladas y que maximicen una recompensa en el largo plazo. El control inhibitorio es una función cognitiva que nos permite regular la conducta, inhibir impulsos y generar procesos cognitivos más selectivos (Munakata, Y. et al., 2011)

El control inhibitorio es un mecanismo de adecuación al medio o al contexto. El control inhibitorio nos permite regular nuestra conducta y ajustar nuestras respuestas en función del entorno donde nos encontramos, podemos adaptarnos mejor a las situaciones y tomar decisiones más acordes con objetivos y las circunstancias específicas.

El control inhibitorio se ha observado en varios mamíferos y animales. Algunas especies han demostrado tener un mayor control inhibitorio en comparación con otras.

Los primates, en particular los grandes simios como los chimpancés, los bonobos y los orangutanes, han sido objeto de extensas investigaciones sobre el control inhibitorio. Se han realizado estudios que demuestran su capacidad para resistir impulsos, inhibir respuestas automáticas y mostrar comportamientos flexibles en diferentes tareas cognitivas (Beran, M. J., Hopkins, W. D. 2018). Los perros se ha observado que pueden resistir el impulso de comer cuando se les pide que esperen, inhibir comportamientos agresivos o juguetones cuando se les da una señal de detención y responder a comandos verbales o gestuales (Bray, E. E., MacLean, E. L., & Hare, B. A. 2014). Experimentos similares existen en cuervos, cetáceos y elefantes (Kabadayi, C., Taylor, L. A., von Bayern, A. M. P., & Osvath, M. 2016).

Es importante mencionar que, si bien es factible y existen test estandarizados para medir las habilidades cognitivas de inteligencia como el Wechsler Adult Intelligence Scale (WAIS), test de memoria o test de atención, la definición de inteligencia es antropocentrista, es decir, es definida por y desde los humanos, con test estandarizados que hace difícil su comparación con otras especies o sistemas.

Inteligencia Artificial

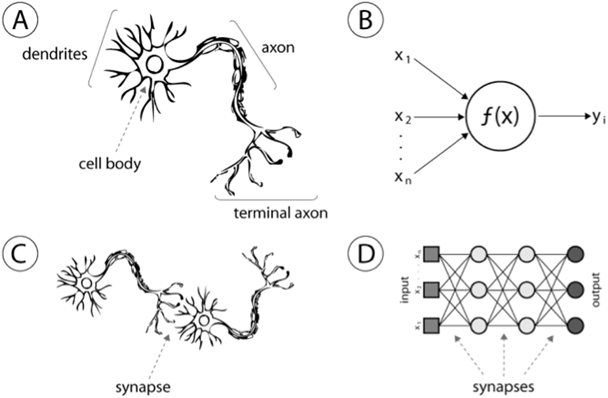

La IA estudia la comprensión y construcción de entidades inteligentes, imitando las funciones y procesos cognitivos de los humanos. Las Redes Neuronales Artificiales (NN) son modelos matemáticos inspirados en el cerebro humano y en el Sistema Nervioso Central (SNC). Las NN están compuestas por nodos interconectados llamados neuronas o unidades de procesamiento, que trabajan en conjunto para realizar tareas de procesamiento de información y aprendizaje (Esposito, A., Faundez-Zanuy, M., Morabito, F. C., & Pasero, E.,2021)

El concepto básico de una red neuronal se basa en imitar el comportamiento de las neuronas biológicas. Cada neurona artificial recibe múltiples entradas, que pueden ser datos numéricos o señales provenientes de otras neuronas y realiza un cálculo utilizando una función de activación. El resultado de esta operación se transmite a través de las conexiones ponderadas a otras neuronas de la red.

En la última década, el campo de la IA ha experimentado avances significativos en el área de Procesamiento del Lenguaje Natural (NLP), Visión por Computadora (CV) y Redes Generativas usando nuevas técnicas de Deep Learning (DL).

Los avances más relevantes en NLP son los modelos de lenguaje basado en Transformers, por ejemplo, Bidirectional Encoder Representations from Transformers (BERT) desarrollado por Google en el 2018. Por otra parte, los avances más significativos en CV son los modelos de Redes Neuronales Convolucionales (CNN) y los algoritmos de Object Tracking y Object Detection por ejemplo, You Only Look Once (YOLO), algoritmo publicado por primera vez en el 2015. Finalmente, las Red Generativas como GAN (Adversarial Generative Network) o GPT (Generative Pre-Train Transformer), fue lanzada en el 2022.

Reinforce Learning

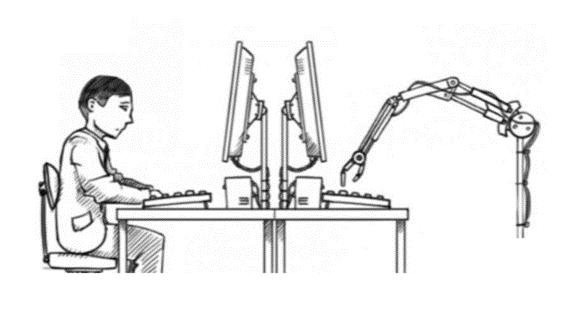

El aprendizaje por refuerzo (RF por sus siglas en inglés: Reinforcement Learning) es una técnica de Machine Learning en el que un agente aprende a tomar decisiones y a desarrollar comportamientos óptimos a través de la interacción con un entorno. En el RL el agente recibe retroalimentación en forma de recompensas o castigos, conocidos como «recompensas» o «señales de refuerzo», en función de las acciones que realiza en el entorno.

El objetivo del agente de aprendizaje por refuerzo es aprender una estrategia que indique qué acción tomar en cada estado del entorno para maximizar la obtención de recompensas a largo plazo. A diferencia del aprendizaje supervisado, en el que se proporciona un conjunto de ejemplos etiquetados, o del aprendizaje no supervisado, en el que no hay retroalimentación explícita, en el aprendizaje por refuerzo el agente debe experimentar y explorar el entorno para descubrir por sí mismo las acciones que conducen a recompensas deseables (Van der Maas, H. L. J., Snoek, L., & Stevenson, C. E. 2021).

El aprendizaje por refuerzo se basa en el concepto de «aprendizaje basado en la experiencia», en el que el agente toma acciones, recibe retroalimentación y actualiza sus estrategias a medida que interactúa repetidamente con el entorno. A través de la iteración de estas interacciones, el agente aprende a través de métodos de prueba y error, ajustando sus acciones para maximizar las recompensas esperadas (Van der Maas, H. L. J., Snoek, L., & Stevenson, C. E. 2021).

Los últimos modelos de los Large Language Model (LLM) por ejemplo GPT, usa técnicas de RL para el Fine Tuning, esto significa que el modelo es ajustarlo a una tarea o dominio específico. Esta mecánica consiste en tomar un modelo previamente entrenado y se realiza un ajuste adicional para mejorar su rendimiento en la tarea específica.

Test de Turing y Habitación China

Test de Turing fue creado por el matemático criptógrafo Alan Turing en 1950, quien planteó la pregunta filosófica matemática: ¿Las máquinas pueden pensar? El experimento postula que si una persona no puede diferenciar si está interactuando con una computadora o con una persona, entonces la computadora habría engañado a la persona y se asume que, por tanto, es inteligente, French, R. M. (2000).

Este experimento puede evaluar la capacidad de una máquina de exhibir un comportamiento inteligente que sea indistinguible del comportamiento de un ser humano. Si la máquina es capaz de responder de manera tan convincente que el evaluador no puede distinguir entre las respuestas de la máquina y las respuestas del ser humano, se considera que ha pasado el “Test de Turing” y se le atribuye un nivel de inteligencia artificial comparable a la humana.

La posición de la IA Fuerte es que las máquinas pueden desarrollar una inteligencia general equiparable a la humana, de esta manera la IA puede comprender el Lenguaje Natural de la misma manera en la que un humano comprende el Lenguaje, es decir, no es simulación de inteligencia, sino que es inteligencia.

La Habitación China

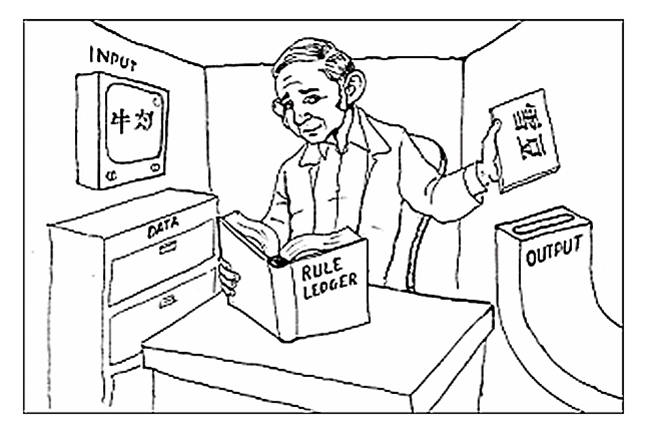

La habitación China es un experimento mental propuesto en 1980 que va a rebatir la validez de la prueba de Turing, Bishop, M., & Preston, J. (2001). El experimento es el siguiente: Existe una habitación llena de manuales, instrucciones, reglas y procedimientos para transcribir chino. Estas reglas son del tipo: “Si entran tales características, escribe tales otras”.

Dentro de la habitación también hay una persona aislada que no sabe hablar chino. Cuando esta persona recibe un texto en el idioma chino, realiza un proceso interno y emite una respuesta coherente en chino.

Afuera de la habitación hay otra persona que, si habla el idioma chino y luego de comunicarse con la habitación, la persona está totalmente convencida que la habitación habla efectivamente el idioma chino, por consiguiente, la habitación logra engañar a la persona que está afuera y el test de Turing es exitoso.

El argumento de la Habitación China sostiene que la persona al interior de la habitación no sabe que le están preguntando ni lo que está respondiendo. La persona simplemente ejecuta una acción mecánica siguiendo algunas reglas sin entender el idioma. El entendimiento es más que la relación entre símbolos y significados dado que existe una representación de estos símbolos.

La crítica contra la IA sostiene que puede parecer que la máquina entienda, pero esto implica una comprensión real, una máquina, por otra parte, puede realizar una acción sin entender necesariamente cómo lo hace.

Para comprender “algo” se debe ser consciente de ese “algo” y las máquinas no son conscientes, por tanto, las máquinas no pueden pensar ni comprender. Las máquinas no son como la mente humana ya que no tienen conciencia de sí misma.

Contraargumento:

La imagen de la habitación China esconde un dualismo cartesiano debido a que postula que la mente tendría una naturaleza independiente y que el fenómeno de lo mental (representado por el humano) no puede ser reducido a lo material (la habitación con el conjunto de reglas).

Si bien es cierto que la persona de la habitación no entiende chino, el sistema completo de la habitación está conformado por la persona, los manuales, las reglas y procedimientos y todos estos en su conjunto si comprenden el idioma chino.

Finalmente, si la conducta de la habitación no es prueba suficiente de que comprende chino, tampoco podría serlo la conducta de ninguna persona. Utilizando ese mismo argumento podríamos postular que los humanos somos una habitación china llena de reglas y creemos entender.

El problema de la Conciencia

Muchas de los argumentos y estudios (con un enfoque dualista) se centran en la incapacidad de la IA de tener conciencia y autoconciencia, en la imposibilidad de que la IA tenga experiencia subjetiva y a la capacidad de reflexión sobre los propios estados mentales. Sin embargo, existen estudios que argumentan que la consciencia puede ser entendida como un estado interno de un sistema computacional que interactúa con su entorno y procesa información. Proponen una teoría de la consciencia desde una perspectiva de ciencias de la computación teórica. Donde un sistema de información sea diseñado para tener un estado interno que represente su consciencia y a la vez sea capaz de interactuar con su entorno. También se postula la existencia de una “Máquina de Turing Consciente” que tenga aspectos de autoconsciencia, experiencia subjetiva, capacidad de atención selectiva y autoconciencia reflexiva, esto significa, que la máquina sea consciente de su propio estado y pueda reflexionar sobre su propia consciencia (Blum, L., & Blum, M. 2022).

El principal problema es que aún no existe un consenso sobre la definición de consciencia, Michel, M. et al., (2019), bajo un enfoque conductista la consciencia va a ser la respuesta a un estímulo o una determinada conducta, mientras que la inconsciencia se va a referir a la ausencia de respuesta o conducta. Por otra parte, desde una perspectiva de la fenomenología la conciencia se entiende como la experiencia subjetiva (Seth, A. K., Bayne, T. 2022).

Attention Is All You Need – Google

El artículo “Attention is all you need” fue publicado originalmente en el 2017 y cuenta con más de 103.837 citas en Google Scholar. Este articulo introduce la arquitectura de red neuronal llamada “Transformer” que aborda la tarea de secuencia a secuencia (seq2Seq) basándose en mecanismos de auto-atención. Este enfoque no solo mejora el nivel de la predicción, sino que también permite una paralelización en el procesamiento mejorando la eficiencia del entrenamiento.

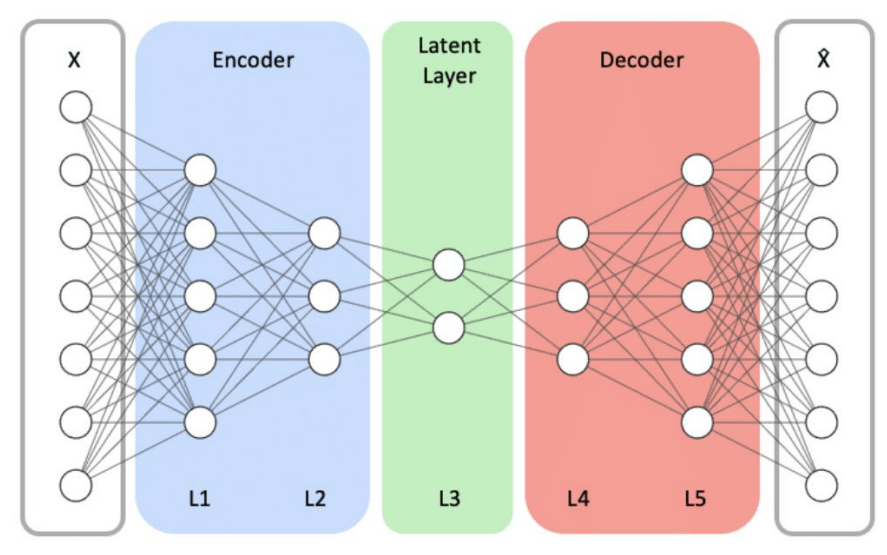

El método de seq2seq es ampliamente usado en tareas de traducción automática, resumen de textos y generación de respuesta en diálogos. Tradicionalmente utiliza un Encoder que procesa la secuencia de entrada y genera un vector de contexto que resume la información y luego un Decoder que utiliza este vector para generar una secuencia de salida (Figura 1).

Figura 1: Autoeconoder. Analysis of autoecoder for Network Instrusion Detection, Youngrok Song, 2021

Las Redes Neuronales Recurrentes (RNN) y las Long Short Term Memory (LSTM) usan loops que toman como input los outputs de los estados anteriores (Figura 2). De esta manera estas arquitecturas son buenas para modelar patrones en secuencias ya sea texto o series de tiempo permitiendo manejar secuencias de longitud variable y capturando dependencias temporales.

Figura 2: RNN. Audio visual speech recognition with multidmodal RNN, Weijiang Feng et al. 2017

El modelo de Embeddings from Language Models (ELMo) usa RNN, específicamente LSTM, capturando dependencias temporales representando cada palabra en usando como contexto de todas las palabras anteriores y todas las palabras posteriores. Sin embargo, la gran limitación de los métodos basados en RNN como ELMo es que requiere procesar la entrada de manera secuencial lo que restringe la posibilidad de paralelizar los cálculos. Sin paralelización efectiva no es factible escalar modelos con millones de parámetros.

El paper de Vaswani et al. Introduce el “Transformer” un tipo de red neuronal basada en mecanismos de auto-atención. El Transformer recibe una oración representada como una secuencia de vectores para luego, mediante ponderaciones y multiplicaciones de matricesir contextualizando estos vectores, produciendo vectores altamente enriquecidos y contextualizados. Los Transformers, a diferencia de las RNN no están limitados por la necesidad de procesar las entradas de manera secuencial, siendo altamente paralelizables e ideal para el uso de GPUs. Por ejemplo, en el 2019 Bidirectional Encoder Representations from Transformers (BERT) replicó la idea de ELMo pero utilizando Transformers en vez de RNN.

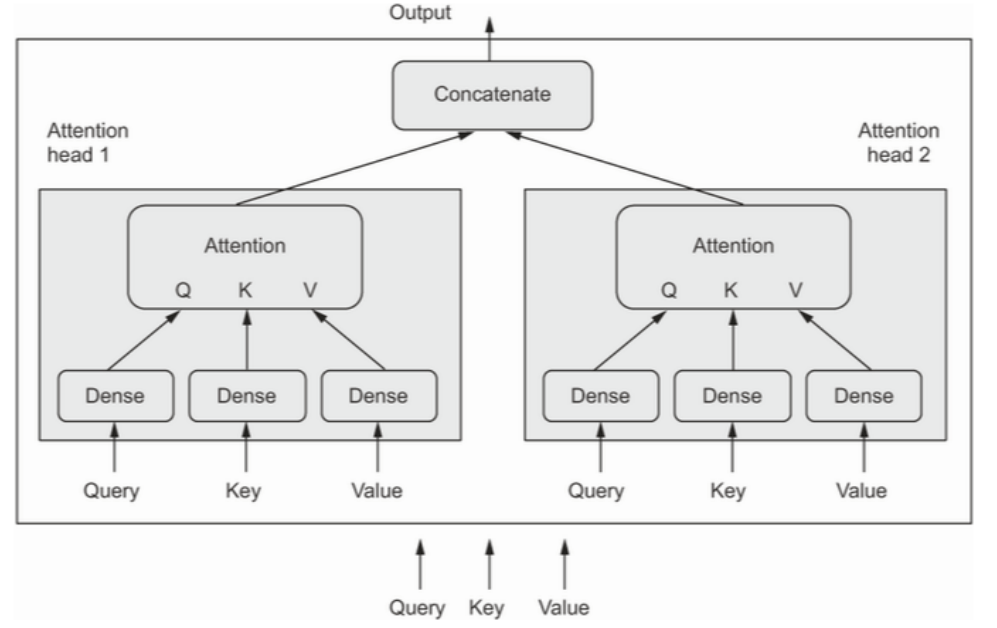

La arquitectura de los Transformers se basa en un modelo de Encoder y Decoder, utilizando embeddings textuales para representar palabras y codificación posicional para mantener la secuencia. El mecanismo de auto-atención, especialmente en su forma Multi-Head Attention, permite al modelo dirigir su atención a diferentes partes de la secuencia de entrada de manera simultánea, lo que resulta beneficioso para comprender contextos y relaciones complejas. Cada «Head” de atención puede capturar distintos tipos de dependencias, lo que enriquece la capacidad del modelo para entender y traducir textos. De manera intuitiva el termino Multi-Head significa que se están usando más de una capa de atención (Figura 4) y el termino de auto-atención dice relación con que no toda la información es igualmente importante, en otras palabras hay “features” más importantes que otros (Figura 3). Ambos mecanismos permiten finalmente una mejor representación vectorial para cada palabra en una frase.

Figura 3: Multi-Head Attention. Deep Learning with Python, Francois Chollet (figure 11.4.2)

Figura 4: Auto-Atención. Deep Learning with Python, Francois Chollet (figure 11.6)

De manera más formal, el método permite calcular la relevancia de diferentes secuencias de entrada. ara esto, primero realiza el producto punto entre las matrices Query (Q) y Key (K) obteniendo los pesos de la atención y luego se multiplican estos pesos por la matriz Value (V) para obtener una salida ponderada (Figura 5).

Figura 5: Multi-Head Attention, Vaswani et al. 2017

Dado que el Transformer no usa recurrencia (como las RNN), necesita una forma de incorporar la información de la posición de cada palabra en la secuencia. Para ello, utiliza codificaciones posicionales sinusoidales, sumadas a los embedding de palabras, para proporcionar información sobre la posición relativa de los tokens dentro de la secuencia (Figura 6: Encoding Posicionales). Esto es crucial para mantener el orden y la estructura gramatical en la comprensión del lenguaje.

Figura 6: Encoding Posicionales, Vaswani et al. 2017

El Transformer sigue una estructura encoder-decoder (Figura 7). El encoder mapea una secuencia de entrada a una serie de representaciones continuas, que luego el decoder utiliza para generar una secuencia de salida. Ambas partes, encoder y decoder, están compuestas de múltiples capas que incluyen mecanismos de atención y redes feed-forward.

Figura 7: Encoder-Decoder, Vaswani et al. 2017

La arquitectura Transformer ha demostrado ser superior en tareas de traducción, logrando establecer nuevos estándares en calidad de traducción con menos tiempo de entrenamiento y mayor paralelización. El Transformer demuestra superioridad sobre modelos previos (RNN) en tareas de traducción, siendo revolucionario en la forma en que se modelan las secuencias de texto, ofreciendo un método paralelizable, rápido y efectivo para tareas complejas de procesamiento del lenguaje natural como la traducción.

Dynamic Model of Segregation – Schelling

El artículo “Dynamic Model of Segregation” de Schelling ha sido citado más de 6500 veces de acuerdo con Google Scholar y representa una obra seminal en el campo de teoría de juegos, modelos basados en agentes y simulación del comportamiento humano. Como consecuencia una gran cantidad de disciplinas desde la economía hasta las ciencias sociales computacionales se han referido a este artículo.

Segregación

La segregación se utiliza tradicionalmente para describir la separación sistemática de individuos o grupos basada en características específicas, como la raza, el género, la religión o etnia. La segregación puede manifestarse de diversas formas, como la segregación racial, donde las personas de diferentes razas viven separadas físicamente en comunidades o áreas geográficas específicas o la segregación socioeconómica, donde las personas de diferentes niveles de ingresos o estatus social se agrupan en comunidades o vecindarios separados. Sin embargo, la segregación también puede ser resultado de elecciones de comportamiento individual como, por ejemplo, la elección de donde vivir, que tipo de trabajo escoger o con quien interactuar.

Sistemas Complejos

Los sistemas complejos son aquellos que exhiben propiedades emergentes en escalas macroscópicas y que no pueden ser explicados a partir de la simple agregación de sus componentes individuales. Estos sistemas están compuestos por muchos agentes que interactúan entre sí, generando patrones colectivos de comportamiento (Becerra, H. 2019). Los sistemas complejos pueden surgir y evolucionar a través de la autoorganización, de tal manera que no son completamente regulares ni completamente aleatorios (Sayama, G. 2015). El concepto de sistemas complejos se puede aplicar al estudio de la economía, la sociedad y la cultura, utilizando metodologías y herramientas tales como modelo basado en agentes, visualización de datos, inteligencia artificial y la teoría de redes.

Incentivos Individuales y Resultado Colectivos

Existen sistemas donde emergen resultados colectivos a partir de mecanismos individuales. En algunos casos incluso cuando las preferencias individuales son débiles o cuando existen incentivos casi imperceptibles, estos, pueden conducir a fenómenos globales completamente distintos y resultados altamente polarizados que emergen a partir de una red de micro interacciones individuales.

Ese es precisamente el argumento central de Schelling abordado por la pregunta de investigación: ¿Cómo puede emerger la segregación a partir de la interacción de las preferencias individuales? Esta pregunta es relevante debido a que aborda el problema fundamental de como funcionan las sociedades.

Implementación de los Modelos de Schelling

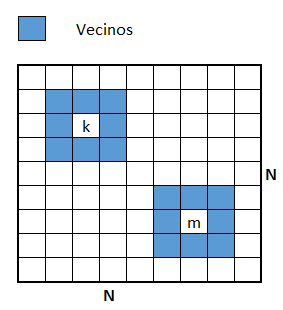

Schelling desarrolló tres modelos: Modelo de distribución lineal, modelo de distribución de área y modelo de vecindario delimitado. Estos modelos son una de las primeras simulaciones basadas en agentes en ciencias sociales (Hatna & Benenson, 2012). En estos modelos, existen agentes que pertenecen a dos grupos distinto de la población y que se mueven en un espacio urbano siguiendo diferentes reglas.

El modelo de distribución lineal considera dos tipos de agentes y los posiciona en una línea que comienza aleatoriamente distribuida. Dado un agente focal se considera como “vecindario” los ocho vecinos más cercanos de este agente. De esta manera se puede medir que agentes están satisfechos o insatisfechos con su vecindario evaluando que fracción de vecinos más cercanos pertenece a su mismo grupo. Los vecinos insatisfechos son aquellos que superan un umbral de satisfacción y tienen un vecindario con una mayor cantidad de personas de otro grupo. Aquellos vecinos insatisfechos podrán cambiarse a una ubicación diferente (Ubareviciene & Tammaru, 2022).

El modelo de distribución de área y el modelo de vecindario delimitado introduce la noción de espacio geográfico, donde una ciudad es modelada teóricamente como un conjunto de pequeños cuadrados similar a un tablero de ajedrez de NxN ubicaciones. Al igual que el modelo lineal ambos grupos (B y R) comienzan aleatoriamente distribuidos, sin embargo, un porcentaje de las ubicaciones (E%) estará vacías. Las reglas de estos modelos son similares al modelo lineal donde cada agente k tiene un parámetro de satisfacción Sk dado por la fracción de vecinos del mismo tipo. Los agentes insatisfechos son aquellos que superan un umbral y tienen un vecindario con una mayor cantidad de personas de otro grupo, aquellos vecinos insatisfechos podrán cambiarse a una ubicación diferente (fig.).

Fig. Tablero de NxN posiciones y vecindades del agente k y m

El modelo de vecindario delimitado introduce el concepto de tolerancia, que representa una regla adicional, que determina la fracción máxima de vecinos de otro grupo que cada agente esta dispuesto a aceptar antes de cambiarse de ubicación. Esto significa que estarán satisfechos si viven en un vecindario que este conformado con un T% o más de su propio grupo. La dinámica de cambiarse de ubicación continuará hasta que se encuentre un equilibrio estable donde todos los agentes estén satisfechos.

Metodología

La metodología utilizada es modelado basado en agentes, metodología que se suele utilizar para estudiar y comprender como funcionan los sistemas complejos. El modelado basado en agentes es un tipo de simulación que permite estudiar el comportamiento de los individuos y cómo sus interacciones pueden conducir a resultados colectivos. Se simulará el comportamiento de los individuos a partir de estos modelos, comenzando con una distribución aleatoria de personas y luego permitiendo que los individuos se cambien de ubicación si no están satisfechos con su actual vecindario.

Simulación y Resultados

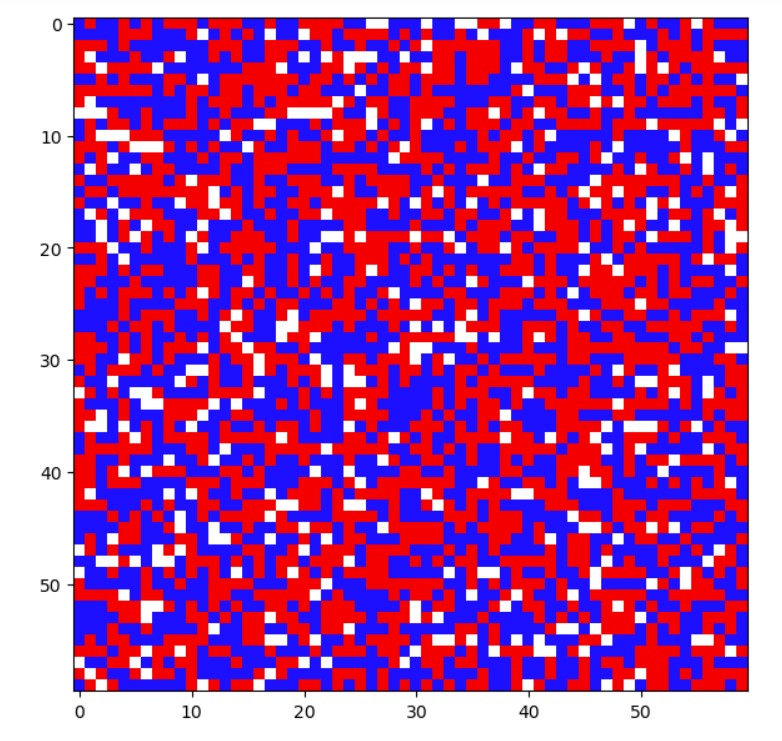

Se utilizarán los siguientes valores para cada parámetro:

- N=60 Por lo tanto significa que existen 60 posiciones.

- E=10% Significa que habrá un 10% de las posiciones vacías en todo momento.

- B/R=1 Significa que existe la misma proporción de agentes Red y Blue

El sistema se inicializa de manera aleatoria con los parámetros previamente definidos (fig.1). Posteriormente se ejecuta la simulación desde un estado inicializado aleatoriamente con un alto grado de integración hacia configuraciones cada vez más segregadas después de 1000 iteraciones. Se evaluará los umbrales de satisfacción de 25%, 40%, 60% y 75% (fig.2).

fig.1: Inicialización aleatoria del sistema con alto grado de integración (Elaboración propia)

fig.3: Sistema luego de 1000 iteraciones para un umbral S de 25%, 40%, 60%, 75% (Elaboración propia)

El principal hallazgo de este estudio es que, aunque los individuos solo tienen una leve preferencia por vivir en vecindarios con una mayoría de su propio grupo, el sistema en su conjunto finalmente se segrega en dos grupos completamente separados. El modelo de Schelling permite entender cómo puede surgir la segregación a partir de la interacción de las preferencias individuales. Muestra que incluso si los individuos no tienen fuertes preferencias por la segregación y muestran un umbral de satisfacción del 40% es decir, estarán satisfechos solo con un 40% de vecinos de su mismo tipo, el sistema en su conjunto puede volverse altamente segregado (Fig. 3). Esto se debe a que las decisiones de los individuos de mudarse se basadas en su entorno local, estas decisiones pueden tener un efecto en cascada en todo el sistema.

Conclusiones

El articulo de Schelling representa una contribución significativa al campo del modelamiento basado en agentes y propone una herramienta valiosa para comprender como preferencias individuales aparentemente pequeñas pueden tener un gran impacto en el sistema general, emergiendo la segregación.

Sin embargo, una de las debilidades de este modelo se basa en la suposición que los individuos tendrían un umbral de tolerancia para el número de personas de otros grupos que viven en su vecindario. Por otra parte, este modelo tampoco considera otros factores que pueden contribuir en la segregación tales como desigualdad económica y discriminación.

Como futuras líneas de investigación el modelo de Schelling podría ser utilizado para explicar ejemplos en el mundo real con datos reales tales como la segregación residencial, la segregación escolar y la segregación laboral. También podría ser utilizado para diseñar programas y desarrollar políticas públicas que aborden la segregación.

Referencias:

- Sayama, H. (2015, August 13). Introduction to the modeling and analysis of Complex Systems. Milne Open Textbooks.

- Becerra, G. (2019). La Teoría de los Sistemas Complejos y la Teoría de los Sistemas Sociales en las controversias de la complejidad. Convergencia revista de ciencias sociales, 27, 1.

- Hatna, E., & Benenson, I. (2012). The Schelling model of ethnic residential dynamics: Beyond the integrated – segregated dichotomy of patterns. Journal of Artificial Societies and Social Simulation: JASSS, 15(1), 1–6.

- Ubareviciene, R., van Ham, M., & Tammaru, T. (2022). 50 years after the Schelling models of segregation. What have we learnt about residential segregation and what are the challenges for the future? SSRN Electronic Journal.

- Mingarelli, L (2021). Schellings model of racial segregation. Implementation and analysis in Python and the emergence of quatisation.

Mercado como Fenómeno Emergente

“The use of Knowledge in Society”, Friedrich Von Hayek & “The Great Transformation”, Karl Polanyi’s

Para Hayek el intercambio económico ha existido siempre y ha sido clave para la prosperidad humana, permitiendo la cooperación entre personas con distintas habilidades persiguiendo sus propios planes y fines. Las interacciones entre los agentes representan un orden espontaneo que emerge de la cooperación de los individuos.

De esta manera, la trayectoria humana podría ser descrita como la evolución del mercado local del trueque hasta el comercio internacional. El mercado podría ser descrito como un fruto evolutivo de las comunidades humanas, en consecuencia, no sería el resultado del diseño humano sino, más bien, emerge de la acción e interacción humana. En otras palabras, el mercado, al igual que el lenguaje, no serían producto de la planificación ni el diseño.

El mercado de precios es una red de informaciones que expresa las preferencias, anhelos y necesidades de millones y millones de individuos persiguiendo sus propios fines, por tanto, este conocimiento no puede estar concentrado en una mente individual (planificador omnisciente), sino que está disperso en millones de personas. El argumento hayekiano considera el mercado como un mecanismo que coordina la información descentralizada, donde los precios son señales de escasez y, por tanto, existiría una imposibilidad de cálculo de precios en la economía centralizada.

Sin embargo, una debilidad del argumento de Hayek es elaborado por Karl Polanyi, quien habla de la falacia economicista de la economía formal donde se entiende o se reduce todas las actividades de interacción al intento de maximizar la eficiencia. De esta manera, postula que el intercambio no siempre es una interacción animada por el anhelo de maximizar las propias preferencias, sino también impulsados por la búsqueda de fines alternativos a este, como el deber de reciprocidad con respecto a los pares o la intención de redistribuir los bienes para satisfacer un criterio de equidad en su acceso.

En la economía real los intercambios no siempre se realizarían de la manera descrita por la economía neoclásica de Marshall o la escuela austriaca de Hayek. Según Polanyi, existirían la reciprocidad y la redistribución y el error de la economía moderna sería reducir toda actividad económica al intercambio.

Por otra parte, Polanyi en la “Gran Transformación”, argumenta que el mercado es un fenómeno relativamente reciente en la historia de la humanidad – por tanto, de un alcance temporal muy limitado- y que históricamente el intercambio estuvo estrechamente ligado a la sociedad, regulado por normas y valores sociales. En consecuencia, la economía de mercado no sería el fruto inevitable o natural de la evolución social, sino que sería el resultado causal del tránsito de formas comunitarias de organización (Gemeinschaft) más cohesionada y de una misma consciencia moral a formas societarias (Gesellschaft) menos cohesionada con un menor grado de vinculo social.

- Hayek, F. A. (1945). The use of knowledge in society. American Economic Review, 35(4), 519–530.

- Polanyi, K. (2018). Economy and society: Selected writings (C. Thomasberger & M. Cangiani, Eds.; 1st ed.). Polity Press.

- Dale, G. (2008). Karl Polanyi’s The Great Transformation: perverse effects, protectionism and Gemeinschaft. Economy and Society, 37 (4), 495–524.

- Peña, C. (2017). Lo que el dinero sí puede comprar.